Por Christine Yue Leonard, editora asociada

La subespecialidad de córnea disfruta de una variedad de tecnologías complementarias que se basan en la inteligencia artificial, para procesar grandes cantidades de datos generados y ayudar a la toma de decisiones clínicas. De hecho, los algoritmos de IA para la detección temprana del queratocono han existido desde el desarrollo de la topografía corneal computarizada a fines de la década de 1980 y principios de la década de 1990.

“Los algoritmos están muy extendidos y funcionan bien”, dice Bernardo T. Lopes, MD, MPhil, PhD, MRCS, FICO, de la Facultad de Ingeniería de la University of Liverpool, Reino Unido, el departamento de oftalmología de la Universidade Federal de São Paulo y miembro del Grupo de Estudio de Tomografía Corneal y Biomecánica de Río de Janeiro. “Al igual que con todo en la vida, siempre estamos buscando mejorar lo que tenemos o retomando los algoritmos de machine learning ya establecidos para implementarlos en dispositivos disponibles comercialmente o en páginas web. Los algoritmos y las bases de datos de IA están apoyando a oftalmólogos de todo el mundo”.

En este artículo, los desarrolladores y expertos en IA comparten cómo se está utilizando la IA para las condiciones corneales, dan consejos para trabajar con algoritmos y discuten las futuras direcciones.

El estado de la IA corneal

Hay muchos tipos de procesos de IA utilizados en la córnea hoy en día. “Prácticamente cualquier proceso de IA puede estar involucrado en el diagnóstico, la clasificación o el tratamiento”, dice el Dr. Lopes. “Algunos incluyen algoritmos que utilizan diferentes arquitecturas de redes neuronales para árboles de decisión de máquinas vectoriales o bosques aleatorios, con diferentes grados de éxito. Los usamos no solo para el cribado, sino también para las cirugías corneales. Tenemos algoritmos que han sido diseñados para predecir los resultados visuales después de la cirugía refractiva y para optimizar la implantación del anillo intracorneal y las incisiones de relajación limbal”.

Gran parte del ruido en las noticias sobre innovaciones en IA en los últimos años se ha centrado en la llegada de dos sistemas autónomos de IA – IDx-DR y EyeArt – para la detección de la retinopatía diabética a gran escala. Los expertos en IA dicen que es posible – aunque menos probable – que la IA corneal siga este camino autónomo. “Antes de la era de la IA, ya habíamos estado haciendo mucho cribado de afecciones de la retina, como DR, sospechas de glaucoma, DMAE y miopía, por lo que agregar la IA simplemente tenía sentido”, explica el experto en IA, Daniel Shu Wei Ting, MD, PhD, del Instituto de Investigación Ocular de Singapur, del Singapore National Eye Centre. “Dicho esto, en comparación con las afecciones de la retina, no hay tantas condiciones corneales que requieran cribados repetidos, especialmente a nivel de la población. Las condiciones de la córnea generalmente requieren evaluaciones especializadas. Basándose en la exploración del panorama del mercado oftalmológico, las enfermedades corneales representan menos que las retinianas, por lo que la mayor parte de la financiación de R&D se destina al segmento posterior”.

Un objetivo que comparten los desarrolladores de IA es lo que el Dr. Ting denomina como la “democratización de la experiencia”. “Hay una falta de especialistas en córnea en muchas partes del mundo”, dice. “Si construimos algoritmos de IA alrededor de los mejores expertos, los empaquetamos e incorporamos en diferentes tecnologías de láser y refracción, sería una forma poderosa de hacer que la cirugía refractiva sea realmente segura para muchos más pacientes. El desarrollo de mejores algoritmos de segmentación, por ejemplo, conducirá a mejores diagnósticos y detección de áreas anormales en el escaneo.

“Las máquinas se están volviendo más inteligentes”, continúa. “Debemos preguntarnos: ¿Cómo utilizamos la IA y los datos para hacer las cosas simples pero seguras? Esta es una tendencia importante en la atención médica en general “. El Dr. Ting, actualmente, está involucrado con varias industrias y compañías de imagen que buscan en esta dirección.

Como miembro editorial de varias revistas, revisadas por pares, muchos proyectos de IA corneal pasan por su escritorio. “La mayoría de los proyectos en el diagnóstico corneal se centran en el dominio de la clasificación”, dice. “La construcción de un clasificador implica conjuntos de datos y una respuesta sí/no para la presencia de la enfermedad. También veo muchos algoritmos de segmentación para las capas corneales que ayudarán en la planificación de cirugías, así como en el seguimiento postoperatorio – ¿Cómo está el injerto?, ¿Hay signos de rechazo temprano, inflamación o infección?”

Detección de queratocono

La naturaleza progresiva de la ectasia hace que la detección temprana sea clave.1 “No necesitamos un algoritmo de IA para decirnos si un paciente tiene queratocono patente”, dice el especialista en córnea Jodhbir S. Mehta, MBBS, FRCOphth, FRCS(Ed), PhD, del Singapore Eye Research Institute. “En cambio, queremos que estos algoritmos diferencien los casos de queratocono subclínico de los ojos normales. Esta es, a menudo, la zona gris”.

“La IA puede ayudarnos a diferenciar los casos subclínicos porque da sentido a signos sutiles que de otro modo no se resaltarían en la cantidad de datos que recopilamos”, dice el Dr. Lopes. “Cuando analizas esta información con inteligencia artificial, construyes todo el panorama”.

Las imágenes de diagnóstico, generalmente, incluyen topografía corneal con sistemas de imágenes basados en los discos de Plácido, imágenes tomográficas en 3-D o Scheimpflug y AS-OCT.2 Los algoritmos de IA integran datos de estos sistemas para diferenciar los casos de queratocono y queratocono forme fruste de los ojos normales utilizando abordajes de IA, como redes neuronales feedforward, redes neuronales convolucionales, soporte de machine learning de vectores y árbol de decisión de clasificación automatizada de la forma corneal.2 Estos algoritmos son altamente precisos para la detección del queratocono, dicen los expertos, con tasas de precisión, sensibilidad y especificidad que van del 92% al 97%.2 Se ha demostrado que la machine learning mejora la capacidad de los dispositivos de imágenes para diagnosticar enfermedades subclínicas.3

Sin embargo, la diferenciación subclínica sigue siendo un desafío, a pesar del hecho de que los algoritmos de IA han dado grandes saltos. Un estudio realizado en 2017, sin vínculos de empresa, examinó la capacidad diagnóstica de tres dispositivos Scheimpflug – Pentacam (Oculus), Galilei (Ziemer) y Sirius (Costruzione Strumenti Oftalmici, Florencia, Italia) – en diferenciar córneas normales de ectásicas.4 La comparación directa no fue posible, ya que cada máquina utiliza diferentes índices para el cribado del queratocono. Los tres dispositivos fueron efectivos para diferenciar los ojos con queratocono de los ojos normales. Sin embargo, los investigadores observaron que los valores de corte proporcionados por estudios anteriores y fabricantes no son adecuados para diferenciar los casos subclínicos de las córneas normales.

El estudio incluyó 42 ojos normales, 37 ojos con queratocono subclínico y 51 ojos con queratocono. Se observó una sensibilidad de diagnóstico del queratocono del 100% en seis parámetros en Pentacam y un parámetro en Galilei. Para el queratocono subclínico, se observó una sensibilidad del 100% para dos parámetros de Pentacam. Todos los parámetros fueron lo suficientemente fuertes como para diferenciar el queratocono (AUC>0.9). Los autores encontraron que la AUC de la derivación total de ectasia mejorada de Belin/Ambrosio y el valor inferior-superior de Pentacam fueron, estadísticamente, similares al índice de predicción de queratocono de Galilei y la probabilidad de queratocono (Kprob) (p=0.27), y a la raíz cuadrada media por unidad de área (RMS/A) de 4,5 mm de Sirius (p=0.55). Para la diferenciación subclínica, BAD-D fue similar al índice de regularidad superficial de Galilei (p=0.78) y significativamente mayor que el RMS/A de 8 mm de Sirius (p=0.002).

En 2018, un algoritmo de machine learning no supervisado desarrollado por Siamak Yousefi, PhD, y colegas, identificó una pequeña cantidad de ojos normales con queratocono leve.5 Los investigadores plantearon la hipótesis de que estos ojos pueden haber tenido FFKC. El algoritmo se entrenó en 12.242 imágenes SS-OCT y analizó 420 componentes corneales principales. En el estudio se analizaron 3.156 ojos con índices de estado de ectasia del 0% al 100 %. El algoritmo alcanzó una especificidad del 97,4% y una sensibilidad del 96,3% para diferenciar el queratocono de los ojos sanos.

Un estudio de 2020 identificó una posible variable predictiva para la diferenciación de enfermedades subclínicas. El estudio describió un sistema de clasificación automatizado que utiliza un clasificador de machine learning para distinguir los ojos clínicamente no afectados de pacientes con queratocono de los ojos normales de control.6 Dos expertos en córnea clasificaron 121 ojos como normales (n=50), con queratocono (n=38) y con queratocono subclínico (n=33). Todos los ojos se sometieron a Scheimpflug y a imágenes de OCT de ultra alta resolución; así, se construyó un modelo de clasificación utilizando todas las características obtenidas en las imágenes. A partir de este modelo de clasificación, el algoritmo fue capaz de diferenciar entre ojos con queratocono normal y subclínico con una AUC de 0,93. Los investigadores señalaron que la variación en el perfil de espesor del epitelio corneal, como se ve en UHR-OCT, fue la variable más fuerte para diferenciar el queratocono subclínico de los ojos normales.

Una revisión sobre la precisión de la machine learning para ayudar en la detección del queratocono, publicada en el Journal of Clinical Medicine este año, informó que la machine learning tiene el potencial de mejorar la eficiencia del diagnóstico, pero “actualmente, los modelos de machine learning han tenido un mal desempeño en la identificación temprana del queratocono a partir de los ojos de control, y que muchos de estos estudios de investigación no siguieron los estándares de los informes establecidos, lo que resultó en el fracaso de la traducción clínica de estos modelos de machine learning“. Los autores sugirieron que esto se debe en parte a la falta de grandes conjuntos de datos y a las diferencias entre los sistemas de imágenes corneales.7

Los expertos señalan que, si bien los algoritmos de IA en sus dispositivos de diagnóstico por imágenes son potentes y consideran una serie de variables, sigue siendo una buena idea considerar los datos sin procesar y confirmar el análisis de la IA con otras pruebas de diagnóstico. La IA todavía no es un sustituto para el juicio médico, dicen.

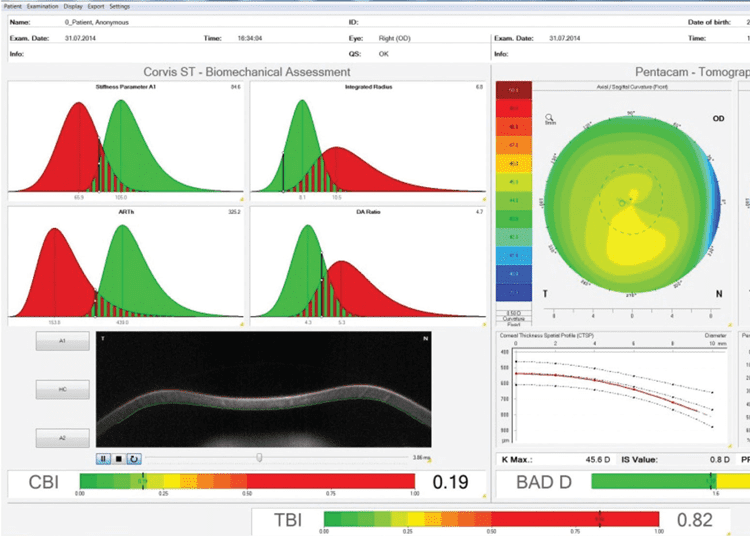

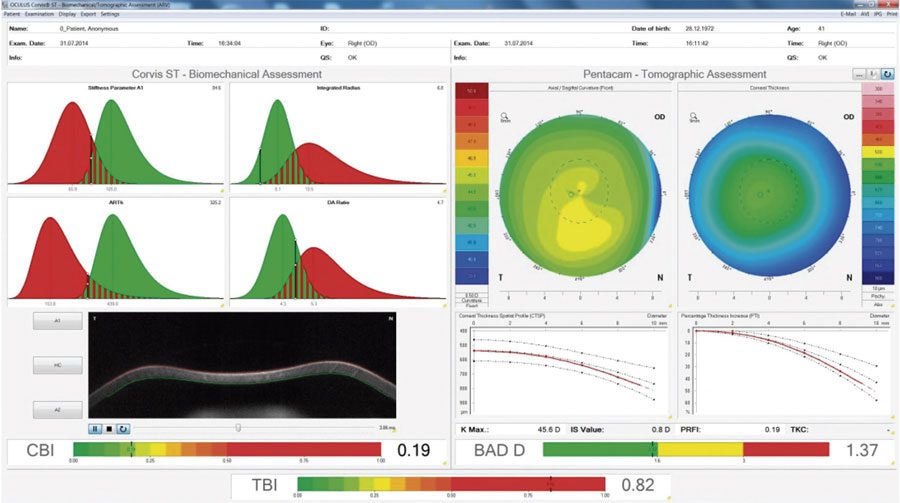

Figura 1. Este es el ojo derecho no operado contralateral de un paciente que desarrolló ectasia post-LASIK en el ojo izquierdo. Se puede observar que, mientras los índices tomográficos y biomecánicos individuales son normales (BAD-D y CBI), la evaluación de estos en combinación con la IA muestra el alto riesgo de este caso. (Imagen cortesía de Bernardo T. Lopes, MD)

Cirugía refractiva

El error de refracción no corregido es una de las principales causas de disminución de la visión en todo el mundo. Los expertos dicen que la detección de cirugía refractiva basada en IA jugará un papel importante a medida que más pacientes busquen cirugía refractiva. Los datos actuales muestran que los modelos de detección basados en IA son eficaces para identificar buenos candidatos quirúrgicos.8 “Utilizo más la IA para detección quirúrgica refractiva”, dice el Dr. Lopes. “Es útil cuando tienes un caso desafiante y dudas sobre si la córnea toleraría la cirugía LASIK”.

Tyler Hyungtaek Rim, MD, MBA, científico clínico en el Singapore Eye Research Institute, y sus colegas, desarrollaron una arquitectura de soporte de decisión clínica de machine learning para determinar la idoneidad de un paciente para la cirugía refractiva.9 Se entrenaron cinco algoritmos sobre datos preoperatorios de múltiples instrumentos y las decisiones clínicas de expertos altamente experimentados para 10 561 sujetos. El modelo de machine learning tuvo una precisión del 93.4% para LASIK y SMILE. El modelo (clasificador de conjunto) con el rendimiento de predicción más alto tuvo una AUC de 0.983 (CI del 95%, 0.977 a 0.987) y 0.972 (CI del 95%, 0.967 a 0.976) en los conjuntos de validación interna (n=2.640) y externa (n=5.279), respectivamente.

Los investigadores informaron que los modelos de machine learning funcionaron estadísticamente mejor que los métodos clásicos, como el porcentaje de tejido extirpado y la puntuación de ectasia de Randleman. Señalaron que los algoritmos de machine learning que utilizan una amplia gama de datos preoperatorios pueden lograr resultados comparables a la detección médica y pueden servir como apoyo seguro y confiable para la toma de decisiones clínicas para la cirugía refractiva.

Los algoritmos de IA también se están utilizando para predecir los resultados de la cirugía refractiva, incluido el riesgo de ectasia post-LASIK.1 Hasta ahora, la literatura sugiere que la IA funciona de manera similar a los cirujanos experimentados en términos de seguridad, eficacia y previsibilidad.

Un modelo de bosque de decisiones creado a partir de vectores de características extraídos de 17.592 casos y 38 parámetros clínicos de pacientes que se sometieron a cirugías LASIK o PRK en un solo centro evaluó, efectivamente, el riesgo con una alta correlación entre los resultados reales y los previstos (p<0.001).10 Los investigadores informaron una eficacia (la relación de CDVA preop y UDVA postop) de 0.7 o más y 0.8 o más en el 92% y el 84.9% de los ojos, respectivamente. La eficacia menor que 0.4 y menor que 0.5 se logró en el 1.8% y el 2.9% de los ojos, respectivamente.

Curiosamente, se observó que los ojos en el grupo de baja eficacia tenían diferencias estadísticamente significativas en comparación con el grupo de alta eficacia, pero eran clínicamente similares. Por ejemplo, los pacientes del grupo de menor eficacia eran algo mayores, tenían un tamaño de pupila escotópica más pequeño y parámetros de tratamiento más bajos para la esfera y el cilindro. El CDVA subjetivo preoperatorio fue la variable más importante en el modelo. Los investigadores también informaron que el análisis de correlaciones mostró una eficacia, significativamente, reducida con el aumento de la edad, el grosor corneal central, la queratometría media y el CDVA preoperatorio (todos p<0.001), y un aumento de la eficacia con el tamaño de la pupila (todos p<0.001).

Tecnología Blockchain para evaluación de IA

Probablemente hayas oído hablar de blockchain en el contexto de criptomonedas como el Bitcoin. Blockchain es un libro maestro descentralizado e inmutable que registra activos digitales con tecnología de cifrado. Cada block (“bloque”) tiene una marca de tiempo, lo que proporciona una prueba de que se produjo una transacción de datos cuando se publicó el bloque. Cada bloque contiene información sobre el bloque anterior, están encadenados y no pueden ser alterados retroactivamente.

¿Cómo se relaciona con la tecnología de IA? “Hay un término llamado tecnología de preservación de la privacidad, o PPT, que ayuda a mitigar los problemas de intercambio de datos”, dice Daniel Shu Wei Ting, MD, PhD, del Instituto de Investigación Ocular de Singapur, del Singapore National Eye Centre. “Los diferentes países tienen diferentes reglas de intercambio y privacidad de datos. Los Estados Unidos, el Reino Unido, la UE y los países asiáticos y del Pacífico tienen diferentes conjuntos de normas. ¿Cómo se puede facilitar las colaboraciones transfronterizas sin compartir datos? ¿Cómo se comparte sin necesidad de transferirlos físicamente de un país a otro?

“Aquí es donde entra en juego el blockchain”, dice. “Blockchain es seguro y es una plataforma inmutable. Una vez que algo se publica, no se puede cambiar. Si hay una actualización, siempre hay un rastro para enseñar el orden en que se cambió algo.

“Hemos puesto a prueba un proyecto que examina cómo podemos usar una plataforma blockchain para gobernar el proceso de pruebas de IA”, continúa el Dr. Ting. “Recibo muchos papers de IA para revisión por colegas, y uno de los desafíos que a menudo enfrentó, especialmente cuando estoy revisando artículos como editor, es que no sé qué tan cierto es el resultado. Todos los estudios informan algo así como una AUC del 98% o una sensibilidad de más del 95%, y todo el mundo afirma tener el mejor software. ¿Cómo se evalúan realmente estos estudios? ¿Cómo se prueban los algoritmos? Algunas revistas, como The Lancet o Nature, tienen una declaración de disponibilidad de datos o una declaración de disponibilidad de algoritmos de IA. Por lo tanto, si solicitan los datos, los investigadores se los enviarán.

“Probé esto una vez y me comuniqué con los investigadores”, dice. “Les dije: ‘Me gustaría probar la reproducibilidad del algoritmo contra lo que se presentó para su publicación’. Me encontré con problemas con las reglas de privacidad de datos. Los investigadores me dijeron: “No puedo enviarte los datos porque mi oficina de transferencia de tecnología me dijo que está en contra de tal y cual regla” o que la IA tiene licencia. Así que sus manos están atadas: ¿Confías en la gente o rechazas el paper? Estas son cosas que están sucediendo con muchos papers de IA en este momento”.

Él dice que el uso de un ecosistema blockchain podría ayudar a crear un entorno confiable. “Es un poco como una auditoría de sus impuestos”, explica. “Puedes presentar tu declaración de impuestos y todo está bien y nadie te molesta. Pero cuando sucede algo inusual, tenemos que investigar. Si un algoritmo de IA obtiene la aprobación de la FDA, y luego llega a su espacio de implementación y la AUC sigue mostrando consistentemente algo así como el 96% o el 97%, entonces no hay problema. Nadie va a abrir la caja negra de tu algoritmo para observarla. Pero, si el documento presentado afirma una AUC del 98% y cuando llega a su implementación en el mundo real su rendimiento es significativamente menor, querremos saber el motivo para poder arreglarlo. Puede ser un error honesto, pero tenemos que ver qué se hizo en el pasado.

“Para hacer esto, volveríamos al algoritmo original y a los conjuntos de datos utilizados. Pero, si retrocede tres o cuatro años, muchos investigadores no pueden proporcionar el mismo conjunto de datos o el mismo algoritmo porque ha habido nuevas versiones y actualizaciones, pero sin registros permanentes de cambios anteriores”, dice.

“Podemos usar blockchain para ayudar a corregir los problemas que puedan surgir”, dice. “Si envía una IA a la FDA, un valor hash viene con sus algoritmos y conjuntos de datos. Si hago una auditoría del algoritmo y los conjuntos de datos cuatro años después, coincidirá con los valores hash originales. Así podremos ver que tal vez fue solo mala suerte y solucionamos el problema”.

—CL

El diagnóstico de cataratas basado en IA y la clasificación de la gravedad mediante fotografías con lámpara de hendidura y fotos de fondo de ojo también ha demostrado éxito con alta precisión, sensibilidad y especificidad.1 Un grupo creó un modelo validado de deep-learning que podía diferenciar la catarata y la LIO de un cristalino normal (AUC>0,99) y detectar cataratas referibles, grados III-IV (AUC>0,91), cataratas subcapsulares y PCO.10

Úlceras corneales

La IA tiene un gran potencial de uso en el diagnóstico de úlceras y distrofias corneales porque estas afecciones son fáciles de visualizar con fotografías u otros diagnósticos. “La causa más común de úlceras corneales, en todo el mundo, son las bacterias, seguidas por los virus, y en ciertas regiones rurales y países, como la India y la China, se ven altos niveles de queratitis fúngica”, dice el Dr. Mehta. “Estamos entrenando algoritmos de IA para diferenciar estas condiciones”.

El Dr. Mehta participó en un estudio de úlceras corneales que demuestra el potencial de la democratización de la experiencia de la IA. “Participamos en un estudio en el que a los oftalmólogos de todo el mundo se le mostró al azar una serie de fotografías de pacientes de la India que eran positivos para queratitis bacteriana o fúngica”, dice. “Medimos la precisión diagnóstica y luego comparamos los resultados de los cirujanos con sede en la India con los de fuera de ese país, como los Estados Unidos, el Reino Unido, Europa y otros países asiáticos. Básicamente pudimos demostrar que, cuando se mira como una cohorte, los cirujanos que pudieron detectar mejor la queratitis fúngica fueron – como era de esperar – los que vieron la mayoría de los casos de queratitis fúngica: los médicos en la India. El software de IA basado solo en un protocolo de imágenes con lámpara de hendidura fue superior a todos los médicos.

“Entonces, lo que esto muestra es que la precisión diagnóstica para los médicos que no trabajan en áreas con altos niveles de queratitis fúngica es menor”, continúa. “En el Reino Unido, probablemente vemos solo unos pocos casos de queratitis fúngica cada año. En Singapur, vemos muchos más casos de infección bacteriana, a pesar de que estamos en una zona de clima tropical.

“Este tipo de software de IA ayudará a mejorar la precisión del diagnóstico”, dice el Dr. Mehta. “Las muestras bacterianas pueden tardar días en cultivarse, y las muestras fúngicas a menudo tardan semanas antes de que obtengamos una respuesta – y, por supuesto, tienes que tratar al paciente mientras tanto. Por lo general tratamos a los pacientes empíricamente, pero con el software podemos tener una idea más temprana de la precisión del diagnóstico. Esto podría ayudar a muchos pacientes, especialmente cuando no tienen acceso a un laboratorio.”

El Dr. Mehta dice que las redes neuronales artificiales (RNA) tienen el potencial de cambiar los resultados más rápidamente y con mayor precisión que los métodos de diagnóstico tradicionales (que implican raspado corneal, microscopía, tinción y cultivo), y tienen una tasa de positividad de cultivo de solo el 33% al 80%.11Una RNA fue capaz de clasificar 39 de 43 úlceras bacterianas y fúngicas correctamente con una precisión del 90,7%, en comparación con una tasa clínica del 62,8% (p<0,01) y una especificidad del 76,5% y el 100% para úlceras bacterianas y fúngicas, respectivamente.12

“Ha habido una transformación digital y ahora hay una mayor aceptación de los diagnósticos virtuales y la telesalud. esto puede revolucionar la forma como se realizan los diagnósticos corneales.” Daniel Shu Wei Ting, MD, PHD

Un informe de 2020 en Nature describe un novedoso algoritmo de deep learning para la fotografía con lámpara de hendidura que tenía un alta sensibilidad y especificidad para detectar cuatro enfermedades corneales comunes: queratitis infecciosa, queratitis no infecciosa, distrofia o degeneración corneal, y neoplasia corneal.13 El algoritmo fue entrenado para detectar la variabilidad detallada de las características de la enfermedad en 5.325 imágenes de superficie ocular de un conjunto de datos retrospectivos. Se probó con 10 oftalmólogos en un conjunto de datos prospectivo de 510 pacientes ambulatorios. La AUC para cada enfermedad fue superior a 0,91, y la sensibilidad y la especificidad fueron similares o mejores que los valores promedio para todos los oftalmólogos. Los investigadores notaron que había similitudes en la clasificación errónea entre los expertos humanos y el algoritmo. Además, citaron la necesidad de mejorar para superar las variaciones en las imágenes tomadas por diferentes sistemas. Pero concluyeron que este algoritmo puede ser útil para el diagnóstico de enfermedades corneales asistidas por computadora.

Uno de los desafíos que la IA tendrá que superar en el diagnóstico de infecciones corneales es la enfermedad concomitante. “Entre el 40%-50% de los casos son infecciones mixtas, y eso nos resultará mucho más difícil para programar, y para que una IA lo detecte”, dice el Dr. Mehta “¿Cómo se diferencia una infección viral de una infección bacteriana y viceversa, o las bacterias polimicrobianas de los hongos? En este momento, el software tampoco le dará una idea sobre la resistencia, aunque podría proporcionar alguna orientación sobre antibióticos u otros tratamientos. Comprender la dinámica de cómo esto afectará el tratamiento será un desafío. Para hacer esto, necesitaremos conjuntos de datos muy grandes para examinar las tasas de respuesta a los medicamentos”.

El Dr. Mehta dice que la IA puede ser ventajosa para analizar in vivo imágenes de microscopía confocal. “Las máquinas de microscopía confocal son fantásticas, pero producen muchas imágenes y datos”, dice. “Analizar y filtrar estas imágenes es algo que se puede hacer utilizando el software de IA, que podría captar quistes acanthamoeboides o filamentos de hifas.

“Un desafío adicional es que las imágenes confocales de infección a menudo son de color muy claro, por lo que se debe comprender la granularidad del software para poder captar buenas imágenes y áreas de interés de un fondo que es muy blanco o está inflamado o con cicatrices”, explica. “A veces, el software perderá cosas, por lo que, nuevamente, se necesitan grandes conjuntos de datos para refinar los algoritmos de entrenamiento y realizar la validación”.

“Un algoritmo de IA es tan bueno como los datos con los que está entrenado”, coincide el Dr. Lopes. “El principal problema que tenemos ahora es el tamaño de los conjuntos de datos utilizados para entrenar algoritmos. Vemos papers publicados con tan solo 30 días de capacitación para realizar una tarea compleja, como combinar topografía y tomografía para detectar ectasias. Es casi seguro que eso sobreajustará los datos de entrenamiento y no podrá funcionar tan bien.

“Otro desafío radica en la propia naturaleza de los datos corneales”, continúa el Dr. Lopes. “Como la mayoría de los datos biológicos, es ruidosa. Hay fluctuaciones aleatorias que interfieren en el efecto de la señal o la característica o el patrón que está tratando de detectar. Si mide el mismo ojo dos veces, no tendrá el mismo resultado debido a estas fluctuaciones aleatorias. Pueden ser tan altos o importantes como para enmascarar una característica real que está tratando de detectar. Por lo tanto, lidiar con el ruido es un desafío para los algoritmos, y es difícil obtener grandes muestras para corregir esto”.

Trasplantes de córnea

Una de las dificultades bien conocidas con DMEK es lograr que el injerto se adhiera al endotelio con la menor manipulación posible. “Hay algunos trabajos que usan software de inteligencia artificial y modelos de machine learning que intentan comprender qué injertos se pegarán y cuáles no, así como el comportamiento de los injertos – ya sea que necesiten o no volver a burbujear después de las cirugías básicas”, dice el Dr. Mehta.

Un estudio presentado en ASCRS, en 2020, anunció un diagnóstico exitoso de rechazo de injerto mediante un nuevo algoritmo autónomo de IA.14 Se tomaron imágenes de 36 ojos con injertos de córnea utilizando AS-OCT, y se utilizó un algoritmo de IA de deep learning de Bascom Palmer para evaluar los escaneos de injerto. Los investigadores compararon los resultados de la IA con los diagnósticos clínicos de los expertos en córnea de Bascom Palmer. Estos expertos diagnosticaron 22 injertos como sanos y rechazaron 14 de ellos. El algoritmo de IA diagnosticó correctamente todos los injertos sanos y 12 de 14 injertos rechazados. Para el diagnóstico de rechazo, la AUC fue de 0,9231 con una sensibilidad del 84,62% y una especificidad del 100%.

Otro estudio publicado en Cornea informó resultados iniciales positivos con un método basado en deep learning para detectar automáticamente el desprendimiento del injerto después de DMEK.15 Los investigadores entrenaron un algoritmo en 1.172 imágenes AS-OCT (609 adjuntas, 563 separadas) para crear un clasificador. La puntuación media de desprendimiento del injerto fue de 0,88 ±0,2 en el grupo separado y de 0,08 ±0,13 en el grupo de injerto adjunto (p<0,001). La sensibilidad fue del 98%, la especificidad el 94% y la precisión el 96%. Los autores dicen que se necesita más trabajo para incluir el tamaño y la posición del desprendimiento del injerto en el algoritmo.

“La decisión final será del cirujano. Esa es una responsabilidad que nunca desaparece” Jodhbirs. Mehta, MBBS, PHD.

El Singapore National Eye Centre publicó un paper en junio de este año utilizando machine learning para analizar en ojos asiáticos factores asociados con la supervivencia del injerto a 10 años.16 El algoritmo incluyó las características del donante, los resultados clínicos y las complicaciones de 1.335 pacientes que se sometieron a DSAEK (n=946) o PK (n=389) por distrofia de Fuchs o queratopatía ampollosa. Los investigadores utilizaron el análisis aleatorio de bosques de supervivencia para determinar el modelo óptimo de regresión de riesgos proporcionales de Cox. Encontraron que el sexo masculino (HR: 1.75, CI del 95%: 1.31 a 2.34; p<0,001) y la mala agudeza visual preoperatoria (HR: 1.60, CI del 95%: 1.15 a 2.22, p=0,005) estaban asociados al fracaso del injerto.

“La IA también se está desarrollando para monitorear a los pacientes después de los trasplantes”, dice el Dr. Mehta. “Observamos el recuento de células endoteliales para tener una idea de qué tan saludables son las células, y esto nos da un marcador sustituto de cuánto tiempo sobrevivirá el injerto. Ahora hay varias herramientas con software disponibles para realizar el conteo de células. El problema es que a veces las imágenes pueden ser precarias; y, si no las tienes de muy buena calidad, no tendrás una idea real de cómo funciona el injerto. El software de IA puede ayudar a proporcionar mejores datos celulares, incluso si la calidad de la imagen es deficiente. Sin embargo, hasta ahora todo esto se ha hecho en un entorno de investigación, no clínico, por lo que queda por ver qué tan útil será esta herramienta de IA para monitorear a los pacientes después del trasplante corneal”.

El Dr. Mehta dice que los avances en nuestra comprensión de la genética de la distrofia de Fuchs pueden ayudar a planificar los procedimientos de trasplante personalizados por IA. “Ahora tenemos mucha más información genética sobre la enfermedad, y creo que existe la oportunidad de vincular las imágenes con la genética”, dice. “Desde el punto de vista quirúrgico, estamos trabajando en enfoques que no requieren la extracción de todo el endotelio, sino solo en un área específica alrededor de la patología de la enfermedad. La IA nos está ayudando a diagnosticar y comprender quién será un buen candidato para un procedimiento como DSO. Un algoritmo podría guiarlo con respecto a cuánto tejido despojar y dónde está el área enferma, específicamente. Nunca tomamos muchas imágenes del endotelio porque solo lo estábamos quitando por completo.”

Adhesión

Muchos de estos nuevos algoritmos necesitan muchísimo trabajo y validación en conjuntos de datos más grandes antes de estar listos para la hora punta clínica. El Dr. Ting dice que un obstáculo adicional que pueden enfrentar es la aceptación por los especialistas en córnea. “Hablando con ellos antes del COVID, muchos no demostraban pensar que la IA puede hacer un trabajo mejor que una tinción de Gram o las sensibilidades culturales actuales, por lo que hace unos años habría dicho que la adhesión de los especialistas en córnea puede tomar algo de trabajo”, dice el Dr. Ting. “Pero como saben, la tecnología se está volviendo más inteligente, el envejecimiento de la población ha resultado en una escasez de experiencia médica, y además tuvimos una pandemia. Así que mucha cosa ha cambiado en la mentalidad de las personas en los últimos dos años. Ha habido una transformación digital, y ahora hay más aceptación de los diagnósticos virtuales y la telesalud. Esto puede revolucionar la forma en que se realizan los diagnósticos corneales”.

¿Qué es lo más importante que un médico debe tener en cuenta cuando usa una herramienta que tiene IA? “Que no es perfecta”, dice el Dr. Mehta. “No hay ningún software que haya visto con una AUC de 0.9999, por lo que siempre habrá una tasa de error. Algunas personas están preocupadas por ser reemplazadas por la IA. En radiología, por ejemplo, la IA puede captar cosas de tomografías computarizadas y similares, y la IA puede ser mejor en eso que los humanos. Pero ¿reemplazará al médico que toma decisiones clínicas? No lo creo.

“Considere todas las máquinas que tenemos ahora para tomografía o biomecánica”, continúa. “Esos sistemas le ayudan a tomar una mejor decisión para su paciente y mejorar su resultado. Creo que ese es el papel de la IA: ayudar al médico a tomar la mejor decisión, no dominar el proceso. La decisión final será del cirujano. Esa es una responsabilidad que nunca va a desaparecer. No dirás: ‘Oh, pero el software de IA me dijo que hiciera tal y tal cosa’. ¡Eso no va a suceder! Hay limitaciones en el uso de la IA, y es importante entender que es una herramienta para guiarlo con la mayor cantidad de conocimiento posible”.

El futuro

“En el futuro – pero probablemente no en un futuro muy cercano – es posible que tengamos sistemas de diagnóstico completamente automatizados para diferentes afecciones corneales, como en otras áreas de la medicina”, dice el Dr. Lopes. “El cribado refractivo es probablemente lo más cercano a esto. Ya tenemos herramientas similares para la detección de la enfermedad de la retina.

El principal desafío para alcanzar este futuro son los datos”, dice. “Necesitas cientos de miles de casos para entrenar bien un algoritmo. Necesitamos centros de datos más centralizados con información de buena calidad, si queremos diagnósticos automatizados adecuados o herramientas de planificación quirúrgica más avanzadas. Pero la IA existe desde hace más de 30 años y hay una gran aceptación de las herramientas actuales. Soy optimista sobre el futuro “.

El Dr. Mehta no tiene vínculos financieros con la tecnología relacionada con la IA. El Dr. Ting es el coinventor de un sistema de deep learning para enfermedades de la retina. El Dr. Lopes es consultor de Oculus.

Bibliografía:

- Lopes BT, Eliasy A, Ambrosio Jr. R. Artificial intelligence in corneal diagnosis: Where are we? Curr Ophthalmol Reports 2019;7:204-211.

- Ting DSJ, Foo V, Yang L, et al. Artificial intelligence for anterior segment diseases: Emerging applications in ophthalmology. Br J Ophthalmol 2021;105:158-168.

- Shi C, Wang M, Zhu T, et al. Machine learning helps improve diagnostic ability of subclinical keraotocnus using Scheimpflug and OCT imaging modalities. Eye Vis 2020;7:48. [Epub September 10, 2020]. Accessed June 3, 2022. https://eandv.biomedcentral.com/track/pdf/10.1186/s40662-020-00213-3.pdf.

- Shetty R, Rao H, Khamar P, et al. Keratoconus screening indices and their diagnostic ability to distinguish normal from ectatic corneas. Am J Ophthalmol 2017;181:140-148.

- Yousefi S, Yousefi E, Takahashi H, et al. Keratoconus severity identification using unsupervised machine learning. PLoS One 2018;13:11:e0205998.

Shi C, Wang M, Zhu T, et al. Machine learning helps improve diagnostic ability of subclinical keratoconus using Scheimpflug and OCT imaging modalities. Eye Vis (Lond.) 2020;7:48. - Cao K, Verspoor K, Sahebjada S and Baird PN. Accuracy of machine learning assisted detection of keratoconus: A systemic review and meta-analysis. J Clin Med 2022;11:478. [Epub January 18, 2022]. Accessed June 3, 2022. https://www.mdpi.com/2077-0383/11/3/478/pdf.

- Ruiz Hidalgo I, Rodriguez P, Rozema JJ, et al. Evaluation of a machine-learning classifier for keratoconus detection based on Scheimpflug tomography. Cornea 2016;35:827-32.

- Yoo T, Ryu I, Lee G, et al. Adopting machine learning to automatically identify candidate patients for corneal refractive surgery. NPJ Digital Medicine 2019;2:50. [Epub June 20, 2019]. Accessed June 3, 2022. https://www.nature.com/articles/s41746-019-0135-8.

- Achiron A, Gur Z, Aviv U, et al. Predicting refractive surgery outcome: Machine learning approach with big data. J Refract Surg 2017;33:9:592-97.

- Wu X, Huang Y, Liu Z, et al. Universal artificial intelligence platform for collaborative management of cataracts. Br J Ophthalmol 2019;103:1553-60.

- Ung L, Bispo PJM, Shanbhag SS, et al. The persistent dilemma of microbial keratitis: Global burden, diagnosis, and antimicrobial resistance. Surv Ophthalmol 2019;64:255-71.

- Saini JS, Jain AK, Kumar S, et al. Neural network approach to classify infective keratitis. Curr Eye Res 2003;27:111-6.

- Gu H, Guo Y, Gu L, et al. Deep learning for identifying corneal diseases from ocular surface slit-lamp photographs. Nature Scientific Reports 2020;10:17851. Accessed June 3, 2022. https://www.nature.com/articles/s41598-020-75027-3.pdf.

- Tolba M, Elsawy A, Eleiwa T, et al. An artificial intelligence (AI) algorithm for the autonomous diagnosis of corneal graft rejection. Presented at ASCRS May 2020 Virtual Meeting.

- Treder M, Lauermann JL, Alnawaiseh M, et al. Using deep learning in automated detection of graft detachment in Descemet membrane endothelial keratoplasty: A pilot study. Cornea 2019;39:2:157-61.

- Ang M, He F, Lang S, et al. Machine learning to analyze factors associated with ten-year graft survival of keratoplasty for cornea endothelial disease. Frontiers In Med 2022;9:831352. Accessed June 3, 2022. https://www.frontiersin.org/articles/10.3389/fmed.2022.831352/pdf.

- Towards Data Science. Accessed June 3, 2022. https://towardsdatascience.com.